프로젝트 : https://gaoruiyuan.com/magicdrivedit/

MagicDriveDiT: High-Resolution Long Video Generation for Autonomous Driving with Adaptive Control

The rapid advancement of diffusion models has greatly improved video synthesis, especially in controllable video generation, which is essential for applications like autonomous driving. However, existing methods are limited by scalability and how control c

gaoruiyuan.com

논문: https://arxiv.org/abs/2411.13807

MagicDriveDiT: High-Resolution Long Video Generation for Autonomous Driving with Adaptive Control

The rapid advancement of diffusion models has greatly improved video synthesis, especially in controllable video generation, which is essential for applications like autonomous driving. However, existing methods are limited by scalability and how control c

arxiv.org

공식 코드: https://github.com/flymin/MagicDriveDiT

GitHub - flymin/MagicDriveDiT: Official implementation of the paper “MagicDriveDiT: High-Resolution Long Video Generation for

Official implementation of the paper “MagicDriveDiT: High-Resolution Long Video Generation for Autonomous Driving with Adaptive Control” - flymin/MagicDriveDiT

github.com

'MagicDriveDiT: High-Resolution Long Video Generation for Autonomous Driving with Adaptive Control'은 2024년 11월 21일에 발표된 논문으로, 자율주행을 위한 고해상도 장시간 비디오 생성을 다룹니다.

이 연구에서는 DiT(Diffusion Transformer) 아키텍처를 기반으로 한 새로운 접근 방식을 제안하여, 기존 방법들이 고해상도 및 장시간 비디오 생성에서 겪는 확장성과 제어 조건 통합의 한계를 극복하고자 했습니다. 이를 위해 플로우 매칭(flow matching)을 활용하여 모델의 확장성을 높이고, 점진적인 학습 전략을 도입하여 복잡한 시나리오를 효과적으로 처리합니다. 또한, 공간-시간 조건 인코딩을 통합하여 공간-시간 잠재 변수에 대한 정밀한 제어를 달성하였습니다. 실험 결과, MagicDriveDiT는 더 높은 해상도와 더 많은 프레임을 가진 현실적인 도로 장면 비디오를 생성하는 데 있어 우수한 성능을 보였습니다. 이로써 자율주행의 다양한 작업에서 비디오 생성 품질과 공간-시간 제어를 크게 향상시켜, 그 활용 가능성을 확장하였습니다.

<< Introduction 절 >>

고해상도 장시간 비디오 생성이 자율주행 분야에서 중요한 역할을 한다는 점을 강조하며, 기존 방법들의 한계와 새로운 접근 방식의 필요성을 논리적으로 설명합니다. 다음은 최대한 세부적으로 분석한 내용입니다:

1. 배경 및 연구 동기

- 비디오 생성의 중요성:

자율주행 차량의 학습과 검증은 다양한 환경과 시나리오에서 이루어져야 합니다. 이는 도로 상황, 날씨 변화, 교통량 등 다양한 요소를 포함하며, 이러한 데이터를 실제로 수집하는 것은 현실적으로 시간과 비용 면에서 큰 제약이 따릅니다.

→ 비디오 생성 기술은 자율주행 연구에 필요한 데이터를 보다 효율적으로 생성할 수 있는 가능성을 제시합니다. - 현실감 있고 다양한 시뮬레이션의 필요성:

단순히 비디오 데이터를 생성하는 것뿐만 아니라, 생성된 비디오가 고해상도, 장시간 지속성, 그리고 현실감을 모두 충족해야 자율주행의 다양한 테스트 조건을 만족시킬 수 있습니다. - 기존 기술의 문제점:

기존의 비디오 생성 기술은 다음과 같은 한계를 가지고 있습니다:- 해상도의 제한:

대부분의 모델은 저해상도 비디오 생성에 적합하며, 고해상도 비디오 생성에서는 품질이 급격히 저하됩니다. - 짧은 비디오 길이:

장시간 비디오를 생성할 때, 프레임 간의 시간적 일관성을 유지하기 어렵고, 생성 품질도 점진적으로 감소합니다. - 조건 제어의 부족:

날씨, 시간대, 교통 상태 등 다양한 조건을 세부적으로 제어할 수 없으므로, 생성된 비디오가 특정 시나리오에 맞추기 어렵습니다. - 확장성 문제:

복잡한 도로 환경을 학습하려면 모델이 점점 더 많은 데이터를 요구하며, 계산 자원이 크게 증가합니다.

- 해상도의 제한:

2. MagicDriveDiT의 핵심 기여

MagicDriveDiT는 위에서 언급한 문제를 해결하기 위해 설계된 모델로, Diffusion Transformer(DiT) 기반의 새로운 접근법을 도입하여 비디오 생성의 품질과 효율성을 크게 향상시킵니다. 구체적인 기여는 다음과 같습니다:

(1) Diffusion Transformer(DiT) 기반 모델

- Diffusion 모델은 점진적으로 데이터를 복원하는 과정을 통해 고품질 이미지를 생성하는 능력이 뛰어나지만, 시간적 의존성을 처리하기에는 한계가 있습니다.

- Transformer 아키텍처는 장기적인 시간적, 공간적 의존성을 학습하는 데 강점이 있습니다. 이를 Diffusion 모델과 결합하여, 장시간 비디오 생성에서도 시간적 일관성과 고해상도를 유지할 수 있습니다.

(2) Adaptive Control (조건 제어)

- 생성되는 비디오가 특정 조건(예: 도로 구조, 날씨, 시간대)에 맞도록 공간-시간 조건 인코딩(spatio-temporal conditioning)을 도입했습니다.

- 이 방법은 비디오 생성 과정에서 조건 변화를 세부적으로 반영할 수 있어, 다양한 시나리오에서의 정확한 제어를 가능하게 합니다.

(3) Flow Matching 기술

- 기존 Diffusion 모델의 학습 방식은 시간이 오래 걸리고, 대규모 데이터에서 효율성이 떨어질 수 있습니다.

- 이를 개선하기 위해 Flow Matching이라는 새로운 학습 기술을 도입했습니다.

- Flow Matching은 데이터 분포를 학습하는 효율성을 높이고, 공간적, 시간적 일관성을 강화하여 더 현실적인 비디오를 생성합니다.

- 이를 통해 고해상도 프레임을 일관되게 연결하며, 모델의 확장성 문제를 해결했습니다.

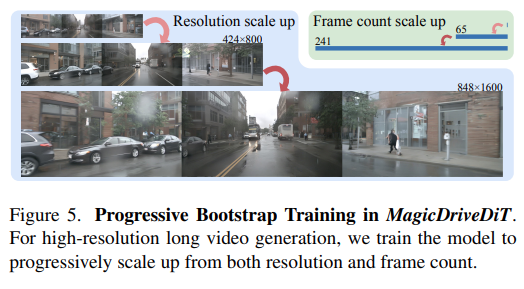

(4) 점진적 학습 전략

- 학습 초기에는 단순한 시나리오(예: 간단한 도로 상황)에서 학습을 시작하고, 이후 점진적으로 복잡한 시나리오(예: 교차로, 교통 체증, 다양한 날씨 조건)로 확장하는 방식입니다.

- 이 접근법은 모델이 복잡한 데이터에서도 안정적으로 학습할 수 있도록 돕고, 최종적으로 현실감 있는 고품질 비디오를 생성하는 데 기여합니다.

3. 성능 및 응용 가능성

- MagicDriveDiT는 기존 방법들에 비해 다음과 같은 성능 개선을 보여줍니다:

- 고해상도 비디오 생성:

최대 4K 해상도의 비디오 생성이 가능하며, 기존의 저해상도 생성 결과와 큰 차이를 보입니다. - 장시간 비디오 생성:

시간적 일관성을 유지하면서 더 긴 비디오를 생성할 수 있어, 자율주행 시뮬레이션에서 보다 다양한 테스트가 가능합니다. - 조건 제어 능력 강화:

환경 조건(예: 날씨 변화, 시간대 전환)을 세부적으로 조정할 수 있어, 특정 상황에 대한 맞춤형 데이터 생성이 가능합니다.

- 고해상도 비디오 생성:

- 응용 가능성:

MagicDriveDiT는 자율주행 시스템의 다양한 요소(예: 객체 인식, 경로 계획, 제어 시스템)의 성능을 평가하고 개선하는 데 사용될 수 있습니다. 또한, 다양한 시나리오를 테스트하기 위한 시뮬레이션 데이터 생성에 적합합니다.

4. 연구의 중요성

Introduction은 MagicDriveDiT가 자율주행 연구에서 필요한 데이터 생성의 새로운 기준을 제시한다고 강조합니다. 특히, 이 모델은 자율주행 시뮬레이션의 품질과 다양성을 크게 향상시킬 수 있는 잠재력을 보여줍니다. 이를 통해 실제 도로 데이터의 의존도를 줄이고, 효율적이고 안전한 자율주행 개발을 가능하게 합니다.

이처럼, Introduction 절은 자율주행 연구에서의 현실적 문제를 강조하면서, MagicDriveDiT의 혁신적인 기여를 논리적으로 정리하여 논문의 중요성과 방향성을 명확히 제시하고 있습니다.

Spatial Latent와 Spatial-Temporal Latent는 둘 다 딥러닝 모델에서 사용되는 잠재 표현(latent representation)이지만, 다루는 데이터의 차원과 그 의미에 있어서 중요한 차이점이 있습니다.

1. Spatial Latent

- 정의:

Spatial Latent은 공간적(2D) 특징에 대한 잠재 표현을 의미합니다. 주로 이미지와 같은 정적인 데이터에서 사용됩니다. - 특징:

- 공간적 위치에 따른 정보를 포함하며, **가로(x)**와 세로(y) 축을 기준으로 데이터를 처리합니다.

- 예를 들어, 이미지의 픽셀 또는 특징맵(feature map) 내에서 각 위치가 가지는 의미를 모델링합니다.

- 주로 CNN(Convolutional Neural Network)에서 사용하는 feature map이나 embedding이 Spatial Latent에 해당합니다.

- 응용 예:

- 이미지 생성, 객체 탐지, 이미지 분할 등과 같은 정적 데이터 기반 작업에 사용됩니다.

- Spatial Latent는 시간 축을 고려하지 않으므로, 각 프레임이 독립적이거나 시간이 중요하지 않은 경우 적합합니다.

2. Spatial-Temporal Latent

- 정의:

Spatial-Temporal Latent는 공간적(2D) 정보와 시간적(temporal, 1D) 정보를 결합한 3D 특징을 의미합니다. 주로 비디오와 같은 동적 데이터를 처리할 때 사용됩니다. - 특징:

- 공간적 위치 정보뿐만 아니라, 시간적 변화를 포함한 특징을 학습합니다.

- 데이터 구조는 3차원적(예: (x, y, t) 형태)으로 확장됩니다. 여기서 t는 시간(time) 축을 나타냅니다.

- 각 시간 단계에서의 공간적 패턴뿐만 아니라, 시간에 따른 변화와 상호작용도 모델링합니다.

- 응용 예:

- 비디오 생성, 행동 인식, 자율주행 시뮬레이션에서의 도로 환경 변화 학습 등 시간의 흐름이 중요한 작업에 사용됩니다.

- 예를 들어, 비디오 프레임 간의 일관성을 유지하면서, 특정 조건(날씨, 시간대 등)에 따라 변화하는 장면을 생성합니다.

3. 차이점

| 특징 | Spatial Latent | Spatial-Temporal Latent |

| 차원(Dimension) | 2D (가로, 세로: (x, y)) | 3D (가로, 세로, 시간: (x, y, t)) |

| 적용 데이터 | 이미지 (정적 데이터) | 비디오 (동적 데이터) |

| 시간 정보 처리 | 시간 정보를 고려하지 않음 | 시간 정보와 공간 정보를 함께 모델링 |

| 주요 사용 사례 | 이미지 생성, 객체 탐지 | 비디오 생성, 행동 인식, 자율주행 시뮬레이션 |

4. 논문에서의 역할

- Spatial Latent:

단일 프레임에서의 공간적 특징을 모델링하는 데 사용됩니다. 예를 들어, 도로의 구조, 차량의 위치와 같은 정보를 학습합니다. - Spatial-Temporal Latent:

프레임 간의 시간적 연속성을 고려하여, 장시간 비디오에서 공간적 변화(예: 도로 상태, 차량 이동, 날씨 변화 등)를 모델링합니다. 이는 비디오의 일관성을 유지하는 데 중요합니다.

5. 비유를 통한 이해

- Spatial Latent는 정지된 사진을 다루는 것처럼, 각 순간의 정적인 장면을 표현합니다.

- Spatial-Temporal Latent는 동영상을 다루는 것처럼, 장면이 시간에 따라 변화하는 과정까지 포함합니다.

MagicDriveDiT 논문에서는 Spatial-Temporal Latent가 특히 중요합니다. 이 모델은 자율주행 시뮬레이션에서 도로 환경의 시간적 변화를 학습하고, 고해상도의 장시간 비디오를 생성하기 위해 이 잠재 표현을 활용합니다.

We adopt the flow matching [9] formulation for diffusion models, implementing it with a DiT-based architecture [30, 47], to enhance scalability. This improves the model’s capacity to efficiently handle complex data across diverse scenarios. To enhance controllability, we use specially designed spatial temporal conditional encoding for spatial-temporal latents from CogVAE [43], enabling precise management of representations. Besides, we adopt a progressive bootstrapping strategy for model training, transitioning from short to long videos, allowing the model to capture intricate details and generalize to complex scenarios. Additionally, we utilize videos of various resolutions and durations to strengthen the model’s generalization ability, enabling the model to synthesize longer videos than those for training.

In summary, the main contributions of this paper include:

- We design an efficient framework, MagicDriveDiT, leveraging progressive bootstrapping to achieve high-quality high-resolution long video generation.

- We develop novel spatiotemporal control for object positions, road semantics, and camera trajectories while maintaining multi-frame, multi-view consistency.

- Our model generalizes well from image to video generation through mixed-resolution and duration training, with extrapolation capabilities, significantly exceeding the resolution and frame number in previous works.

diffusion models을 위해 flow matching formulation 를 사용했다는데, 이게 뭐야?

Flow Matching Formulation은 Diffusion Models에서 데이터 분포를 학습하는 효율적이고 안정적인 방식 중 하나입니다. 이 개념을 이해하려면 Diffusion Models의 기본 아이디어와 Flow Matching의 역할을 차근차근 살펴보아야 합니다.

1. Diffusion Models의 기본 아이디어

- Diffusion Models는 데이터를 점진적으로 노이즈 추가(forward process)와 노이즈 제거(reverse process)를 통해 학습합니다.

- Forward Process:

- 데이터에 점진적으로 노이즈를 추가하여, 점차 정규 분포(Gaussian Distribution)로 바꿉니다.

- 예를 들어, 깨끗한 이미지를 점점 흐릿하게 만들거나 노이즈를 추가하는 과정입니다.

- Reverse Process:

- 노이즈가 가득 찬 상태에서 출발하여 점진적으로 노이즈를 제거하고, 원래 데이터 분포를 복원합니다.

- 이 과정에서 노이즈 제거 함수를 학습하는 것이 핵심입니다.

2. Flow Matching Formulation이란?

Flow Matching은 Diffusion Models의 학습 과정에서 데이터 분포를 효과적으로 모델링하기 위한 새로운 접근 방식입니다. 이는 기존의 Score Matching 기반 Diffusion Models의 한계를 해결하고자 고안되었습니다.

(1) Score Matching vs. Flow Matching

- Score Matching:

- 데이터 분포의 스코어 함수(데이터 분포의 로그 확률 밀도 함수의 기울기)를 추정합니다.

- 노이즈 제거 역학을 학습하기 위해 데이터의 스코어를 추적하는 방식입니다.

- 단점: 복잡한 데이터 분포에서 학습 효율이 낮거나 계산이 비효율적일 수 있습니다.

- Flow Matching:

- 데이터 분포의 변화 과정을 **연속적인 흐름(flow)**으로 모델링합니다.

- 데이터가 한 분포에서 다른 분포로 이동하는 과정(즉, 시간에 따른 데이터 변환 경로)을 직접 학습합니다.

- 이를 통해 데이터의 동적 변화에 대해 더 효율적으로 학습할 수 있습니다.

(2) Flow Matching의 핵심 아이디어

- 데이터를 벡터 필드(vector field)로 표현하여, 데이터가 시간에 따라 어떻게 이동하는지를 모델링합니다.

- 벡터 필드의 방향과 크기를 학습하여, 노이즈 제거 과정뿐만 아니라 데이터의 동적 경로 전체를 추적합니다.

- 수학적으로, 이는 데이터 분포 간의 Optimal Transport Problem과 관련이 있습니다.

- Optimal Transport는 두 분포를 연결하는 최소 비용 경로를 찾는 문제입니다.

- Flow Matching은 이를 기반으로, 데이터가 한 분포에서 다른 분포로 이동하는 최적의 흐름을 학습합니다.

(3) 장점

- 효율성: 데이터의 분포 변화를 더 직관적이고 안정적으로 학습할 수 있습니다.

- 스케일 확장성: 복잡한 데이터와 시나리오에서 학습 안정성이 높아지고, 대규모 데이터 분포를 효과적으로 처리할 수 있습니다.

- 연속적 제어: Flow Matching은 데이터 변화의 전체 경로를 학습하기 때문에, 다양한 조건에서 모델을 더 쉽게 제어할 수 있습니다.

3. MagicDriveDiT에서의 역할

논문에서는 Flow Matching을 사용하여 Diffusion Models의 **확장성(scalability)**을 크게 향상시켰다고 설명합니다.

- 확장성 문제 해결:

Diffusion 모델이 고해상도 비디오 및 장시간 비디오를 처리하려면 매우 복잡한 데이터 분포를 다뤄야 합니다. Flow Matching은 이러한 복잡한 분포를 더 효율적으로 학습할 수 있도록 돕습니다. - 다양한 시나리오 처리:

Flow Matching을 통해 데이터가 시간과 공간적으로 어떻게 변화하는지를 더 잘 학습함으로써, 다양한 환경(예: 도로 조건, 날씨 변화)에서 안정적인 비디오 생성을 가능하게 합니다.

4. 비유를 통해 쉽게 이해하기

- 기존 방식 (Score Matching):

데이터가 목표 지점으로 이동할 때, 각 순간마다 어디로 가야 할지의 방향만 알려주는 것과 비슷합니다. - Flow Matching:

데이터가 시작점에서 목표 지점까지 전체 경로를 설계하여, 데이터가 자연스럽게 이동하도록 만드는 방식입니다. 이는 마치 자동차의 네비게이션처럼 최적 경로를 직접 계산하는 것과 비슷합니다.

요약하면, Flow Matching Formulation은 Diffusion Models에서 데이터를 더 효율적이고 안정적으로 학습할 수 있도록 돕는 방법이며, MagicDriveDiT에서는 이를 통해 고해상도 장시간 비디오 생성의 확장성을 강화했습니다.

<관련 논문>

Boosting Latent Diffusion with Flow Matching

Visual synthesis has recently seen significant leaps in performance, largely due to breakthroughs in generative models. Diffusion models have been a key enabler, as they excel in image diversity. However, this comes at the cost of slow training and synthes

arxiv.org

Flow Matching for Generative Modeling

We introduce a new paradigm for generative modeling built on Continuous Normalizing Flows (CNFs), allowing us to train CNFs at unprecedented scale. Specifically, we present the notion of Flow Matching (FM), a simulation-free approach for training CNFs base

arxiv.org

flow matching 을 위해서, DiT-based architecture 를 제안한거야?

DiT-based architecture(Diffusion Transformer 기반 아키텍처)는 Flow Matching을 위해 새로 제안된 것이 아닙니다. MagicDriveDiT 논문에서는 Flow Matching과 DiT-based architecture를 결합하여 Diffusion Models의 확장성과 효율성을 높이는 데 사용합니다. 이를 각각의 역할로 구분해서 보면 이해하기 쉬울 것입니다.

1. DiT-based Architecture의 역할

- **DiT (Diffusion Transformer)**는 Transformer 구조를 기반으로 한 Diffusion Models 아키텍처입니다.

- Transformer는 **장기적 의존성(long-range dependency)**을 학습하는 데 강점이 있기 때문에, 고해상도 데이터나 장시간 비디오처럼 복잡한 데이터에 적합합니다.

- 기존의 CNN 기반 Diffusion Models가 가질 수 있는 한계를 극복하기 위해, DiT 구조는 Transformer를 사용하여 더 강력한 표현력을 제공합니다.

- MagicDriveDiT에서 DiT를 채택한 이유:

- 비디오 데이터는 시간적, 공간적 의존성이 크기 때문에, 이를 학습하기 위해 Transformer 구조가 적합합니다.

- Diffusion 모델의 확장성(scalability)을 강화하고, 복잡한 시나리오에서 고해상도 장시간 비디오를 효과적으로 생성하기 위해 DiT를 사용합니다.

2. Flow Matching의 역할

- Flow Matching은 Diffusion Models에서 데이터의 노이즈 제거 역학을 더 효율적으로 학습하기 위한 학습 방법론입니다.

- 기존의 Score Matching 방식보다 학습 효율성이 높고 안정적입니다.

- MagicDriveDiT에서는 Flow Matching을 도입하여 Diffusion 모델의 학습 과정을 최적화합니다.

3. 두 방법의 결합

- MagicDriveDiT에서는 Flow Matching과 DiT-based Architecture를 결합하여 서로의 강점을 극대화했습니다:

- DiT-based Architecture는 장시간 비디오에서의 공간-시간적 의존성을 잘 학습합니다.

- Flow Matching은 복잡한 데이터 분포를 효율적으로 모델링하여 학습 과정을 안정적이고 확장 가능하게 만듭니다.

- 결론적으로, Flow Matching은 Diffusion 모델의 학습 방식을 개선하고, DiT-based Architecture는 데이터를 더 잘 표현하는 구조를 제공합니다. MagicDriveDiT는 이 두 가지를 통합하여 고해상도, 장시간, 다양한 조건의 비디오 생성을 가능하게 했습니다.

따라서, DiT-based architecture는 Flow Matching을 위해 새롭게 제안된 것이 아니라, 두 기술이 서로의 강점을 보완하는 형태로 사용된 것입니다.

원래 diffusion 모델은 transformer 를 사용하지 않고 conv 을 사용하는지?

원래의 Diffusion Models는 주로 **Convolutional Neural Networks (CNNs)**를 사용하여 설계되었습니다. 초기 Diffusion Models는 이미지와 같은 **공간적 데이터(spatial data)**를 처리하기 위해 CNN 기반 구조를 채택했으며, 이는 Diffusion Models의 기본적인 특징입니다.

1. 초기 Diffusion Models와 CNN

- 왜 CNN이 사용되었나?

- CNN은 이미지와 같은 2D 데이터에서 지역적 특징(local features)을 학습하는 데 강점이 있습니다.

- Diffusion Models는 이미지를 처리하거나 생성하는 경우가 많았기 때문에 CNN 기반 아키텍처가 자연스럽게 채택되었습니다.

- 대표적인 CNN 기반 Diffusion Models

- DDPM (Denoising Diffusion Probabilistic Models):

Diffusion 모델의 기본 구조로 CNN을 사용해 이미지를 점진적으로 노이즈에서 복원하는 과정을 학습합니다. - Latent Diffusion Models (LDMs):

고해상도 데이터를 처리하기 위해 데이터를 잠재 공간(latent space)으로 변환한 후, CNN을 사용해 효율적으로 복원합니다.

- DDPM (Denoising Diffusion Probabilistic Models):

2. Transformer 기반 Diffusion Models의 등장

Transformer 기반 Diffusion Models는 최근 몇 년간 고해상도 이미지나 **복잡한 시공간 데이터(spatio-temporal data)**를 처리하기 위한 대안으로 등장했습니다.

Transformer는 CNN과 달리 **장기 의존성(long-range dependency)**을 모델링하는 데 강점이 있어 비디오 생성과 같은 복잡한 작업에서 유리합니다.

(1) CNN의 한계

- CNN은 지역적 정보는 잘 처리하지만, 데이터의 장기 의존성을 학습하는 데 약합니다.

- 예: 비디오의 시간적 연속성을 처리하기 어렵습니다.

- 고해상도 데이터에서 계산 비용이 급격히 증가합니다.

(2) Transformer의 장점

- Transformer는 Self-Attention 메커니즘을 통해 데이터의 전역적(global) 의존성을 학습합니다.

- 이를 통해 고해상도 데이터와 장시간 데이터를 더 잘 처리할 수 있습니다.

- 공간적, 시간적 정보를 동시에 모델링하는 데 강점을 가집니다.

3. Diffusion Models와 Transformer

- 최근 연구에서는 Transformer를 Diffusion 모델에 통합하여 CNN의 한계를 극복하고 있습니다.

- 대표적인 사례:

- DiT (Diffusion Transformer): Transformer를 기반으로 한 고해상도 이미지 및 비디오 생성 모델.

- Video Diffusion Models: 비디오의 시공간적 특징을 학습하기 위해 Transformer를 활용.

4. CNN과 Transformer의 비교

| 특징 | CNN 기반 Diffusion Models | Transformer 기반 Diffusion Models |

| 데이터 유형 | 이미지, 정적 데이터 | 비디오, 시공간 데이터 |

| 지역적 학습 | 지역적(local) 정보 학습에 강함 | 전역적(global) 의존성 학습 가능 |

| 고해상도 처리 비용 | 고해상도 처리 시 비용 증가 | Attention 메커니즘을 통해 효율적 처리 가능 |

| 장기 의존성 학습 | 약함 | 강함 |

결론

- 초기 Diffusion Models는 대부분 CNN 기반으로 설계되었으며, 이미지 생성 작업에 적합했습니다.

- Transformer는 비디오와 같이 시공간적 의존성(spatial-temporal dependency)이 중요한 데이터에서 더 나은 성능을 보이며, 최근 고해상도 및 복잡한 데이터 생성 작업에서 선호되고 있습니다.

- MagicDriveDiT와 같은 최신 모델은 Transformer를 기반으로 설계되어, CNN의 한계를 극복하고 복잡한 비디오 생성 작업을 효과적으로 처리합니다.

이 논문에서 설계한 DiT-based architecture 에 대해서..

MagicDriveDiT 논문에서 제안한 DiT-based architecture(Diffusion Transformer 기반 아키텍처)는 고해상도 장시간 비디오 생성을 목표로 설계된 구조입니다. 이 아키텍처는 기존 CNN 기반 Diffusion 모델의 한계를 극복하고, Transformer의 강력한 전역적 학습 능력을 활용하여 공간적 및 시간적 의존성을 효율적으로 처리합니다. 논문에서 제안된 구조의 특징과 설계를 하나씩 자세히 살펴보겠습니다.

1. DiT-based Architecture의 주요 설계 목적

- 장기적 의존성(long-range dependency) 학습:

고해상도 및 장시간 비디오 생성에서 필수적인 공간적, 시간적 의존성을 Transformer 구조를 통해 모델링. - 확장성(scalability) 향상:

고해상도 및 다양한 비디오 길이를 효과적으로 처리하기 위해 효율적이고 유연한 구조를 채택. - 다양한 제어 가능성(controllability):

공간적-시간적 조건(spatial-temporal conditions)을 효과적으로 반영하여, 생성된 비디오의 세부 조건(예: 시간, 날씨, 도로 상황 등)을 제어.

2. DiT-based Architecture의 구성 요소

MagicDriveDiT에서 제안한 DiT 아키텍처는 다음과 같은 핵심 요소로 구성됩니다:

(1) Transformer 블록 (Diffusion Transformer)

- Self-Attention 메커니즘:

- Self-Attention은 입력 데이터의 각 요소가 다른 모든 요소와의 관계를 학습할 수 있도록 합니다.

- 이는 특히 비디오 데이터와 같이 시공간적 의존성이 강한 데이터에서 중요한 역할을 합니다.

- MagicDriveDiT에서는 2D 공간적 정보와 1D 시간적 정보를 동시에 학습하기 위해 공간-시간적 Self-Attention을 사용합니다.

- 멀티헤드 Self-Attention (Multi-Head Self-Attention):

- Transformer의 핵심 요소로, 입력 데이터의 다양한 패턴을 병렬적으로 학습.

- MagicDriveDiT는 비디오의 고해상도 특성을 반영하기 위해 멀티헤드 Self-Attention을 강화했습니다.

(2) Spatial-Temporal Conditional Encoding

- 공간-시간 조건 인코딩:

- 비디오 생성에서 특정 조건(예: 날씨, 시간대)을 반영하기 위해, CogVAE를 통해 학습된 Spatial-Temporal Latents를 사용.

- 이 Latent들은 Transformer에 입력으로 주어지며, 비디오의 생성 과정에서 조건 제어를 가능하게 합니다.

- 특징:

- 공간적 정보(도로 구조, 차량 위치 등)와 시간적 정보(프레임 간 변화, 이동 경로 등)를 결합하여 모델링.

- 각 프레임의 독립적인 공간적 특징뿐만 아니라, 프레임 간 시간적 연속성을 유지.

(3) Flow Matching 통합

- MagicDriveDiT는 Flow Matching 학습 전략을 아키텍처에 통합하여 효율성과 학습 안정성을 향상.

- 이 방법은 Transformer 구조가 고해상도 데이터의 복잡한 분포를 더 잘 학습하도록 지원.

(4) 프로그레시브 부트스트래핑 (Progressive Bootstrapping)

- 학습 초기에는 짧은 비디오로 시작하여 --> 점진적으로 긴 비디오를 학습.

- 이를 통해 모델이 점차적으로 --> 더 복잡한 시공간적 의존성을 학습할 수 있도록 설계.

3. 동작 원리

- 입력 처리:

- 입력 비디오(또는 초기 노이즈 상태)와 함께, CogVAE에서 생성된 Spatial-Temporal Latents를 Transformer의 입력으로 전달.

- Spatial-Temporal Conditional Encoding을 통해, 생성할 비디오의 조건(날씨, 시간대 등)을 모델링.

- Transformer 블록:

- Multi-Head Self-Attention을 통해 비디오의 공간적 및 시간적 특징을 학습.

- Flow Matching을 통해 데이터의 분포 변화(즉, 노이즈 제거 과정)를 더 효율적으로 모델링.

- Output Generation:

- 최종적으로 고해상도 장시간 비디오를 생성하며, 입력 조건에 따른 비디오 제어가 가능.

4. 기존 DiT와의 차별점

MagicDriveDiT의 DiT-based architecture는 기존의 DiT와 비교하여 다음과 같은 차별점을 가집니다:

| 특징 | 기존 DiT | MagicDriveDiT의 DiT |

| 데이터 유형 | 이미지 중심 | 비디오 중심 |

| 조건 반영 | 없음 | Spatial-Temporal Conditional Encoding 사용 |

| 학습 전략 | 일반 학습 | Progressive Bootstrapping 도입 |

| 확장성 | 고해상도 이미지 | 고해상도 및 장시간 비디오 |

5. MagicDriveDiT의 장점

- 비디오 생성 품질:

기존 CNN 기반 Diffusion 모델과 비교해 더 자연스럽고, 시간적 일관성이 뛰어난 비디오를 생성. - 조건 제어 능력:

Spatial-Temporal Conditional Encoding을 통해, 비디오 생성 과정에서 특정 조건(날씨, 시간대 등)을 정밀하게 조정 가능. - 확장성:

Flow Matching과 Transformer 구조의 조합으로 고해상도 장시간 비디오 생성에서도 안정적인 성능.

결론

MagicDriveDiT의 DiT-based architecture는 Transformer의 전역적 학습 능력을 활용하여, 공간적-시간적 의존성이 중요한 비디오 데이터를 효과적으로 처리합니다. 특히, Flow Matching, Spatial-Temporal Conditional Encoding, 그리고 Progressive Bootstrapping을 통해 모델의 성능과 유연성을 크게 향상시켰습니다. 이를 통해 자율주행과 같은 응용 분야에서 고해상도, 장시간 비디오 생성의 새로운 기준을 제시합니다.

7. Conclusion and Discussion

In this paper, we presented MagicDriveDiT, an innovative framework for high-resolution and long video synthesis with precise control, specifically tailored for applications like autonomous driving. By leveraging the DiT architecture and Flow Matching, MagicDriveDiT effectively addresses the challenges of scalability and geometry control in video generation. Our approach introduces novel spatialtemporal conditional encoding and a progressive bootstrapping strategy with variable length and resolution adaption, enhancing the model’s generalization ability. Extensive experiments demonstrate that MagicDriveDiT generates realistic videos that maintain spatial and temporal coherence, significantly surpassing previous methods in resolution and frame count. This work advances video synthesis and opens new possibilities for simulations and other applications in autonomous driving.

'Deep Learning > 장면 스타일 변환' 카테고리의 다른 글

| MagicDrive: Street View Generation with Diverse 3D Geometry Control (1) | 2024.12.14 |

|---|